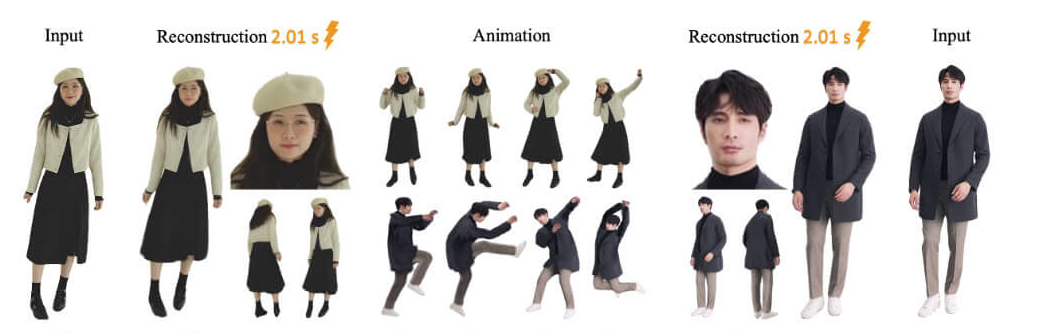

알리바바가 선보인 LHM(Large Animatable Human Reconstruction Model)은 단 한 장의 사진으로 3D 애니메이션 인간 아바타를 만들어내는 놀라운 기술이다. 이 도구는 AI의 힘을 활용해 평범한 이미지를 생동감 넘치는 3D 모델로 변환하며, 복잡한 후처리 없이도 높은 품질을 자랑한다. 영화 제작, 게임 개발, 소셜 미디어 콘텐츠 창작 등 다양한 분야에서 활용 가능성이 열려 있어 많은 이들의 관심을 끌고 있다. 이 글에서는 LHM의 특징과 작동 방식, 공식 자료에서 확인할 수 있는 정보를 알아보고자 한다.

LHM의 탄생과 기술적 배경

LHM은 알리바바의 퉁이 랩(Tongyi Lab)에서 개발된 모델로, 단일 이미지에서 3D로 움직이는 인간 아바타를 빠르게 재구성하는 데 초점을 맞췄다. 기존의 3D 인간 재구성 기술은 정적인 모델에 머물렀거나, 동영상 기반으로 높은 품질을 얻기 위해 많은 시간과 제어된 환경이 필요했다. 반면 LHM은 멀티모달 트랜스포머라는 첨단 아키텍처를 활용해 단일 이미지에서 한 번의 처리로 고해상도 3D 아바타를 만들어낸다.

핵심은 3D 가우시안 스플래팅(3D Gaussian Splatting)이라는 표현 방식이다. 이 방식은 점 기반 렌더링을 통해 복잡한 형상과 텍스처를 효율적으로 처리하며, 실시간 애니메이션까지 가능하게 한다. 알리바바 공식 사이트(stability.ai와는 별개로 LHM 전용 페이지인 lhm.alibabacloud.com)에서는 이 기술이 “몸의 위치 정보와 시각 데이터를 융합해 의복의 디테일과 얼굴의 정체성을 보존한다”고 설명한다. SNS 에 올라온 한 사용자의 반응을 보면, “사진 한 장으로 3D 캐릭터가 몇 초 만에 완성되다니 믿기지 않는다”며 놀라움을 감추지 못했다.

LHM의 강점과 한계

LHM의 가장 큰 매력은 속도와 품질의 조화다. 공식 자료에 따르면, 이 모델은 단 몇 초 만에 애니메이션 가능한 아바타를 생성하며, 얼굴과 손 같은 세부 영역도 별도 후처리 없이 자연스럽게 구현한다. 특히 얼굴 피라미드 인코딩이라는 기법을 도입해 다중 스케일의 얼굴 특징을 집약적으로 처리하며, 이는 기존 모델 대비 얼굴 정체성과 미세 디테일을 더 잘 살려낸다. 테스트 결과, DeepFashion 같은 데이터셋에서 의복 주름과 텍스처 선명도가 경쟁 모델을 압도했다.

하지만 완벽하지 않은 부분도 있다. 복잡한 포즈나 극단적인 각도의 이미지를 처리할 때는 일반화 능력이 다소 떨어질 수 있다. 공식 GitHub 페이지(github.com/aigc3d/LHM)에서도 “실제 영상 데이터의 편향된 뷰 분포가 한계로 작용한다”며, 드문 포즈에서는 결과물이 불안정할 수 있다고 밝혔다. 또한 동적인 배경이나 여러 사람이 얽힌 장면에서는 아직 개선이 필요하다는 의견이 제기된다. 이런 점들은 향후 업데이트와 데이터 확충으로 보완될 여지가 충분하다.

공식 사이트와 자료에서 확인할 수 있는 정보

알리바바의 LHM 전용 페이지와 GitHub 저장소는 이 기술에 대한 풍부한 정보를 제공한다. 주요 내용을 정리하면 다음과 같다:

- 주요 기능: 단일 이미지에서 3D 아바타 생성, 실시간 렌더링, 포즈 기반 애니메이션 지원.

- 성능: LHM-0.5B와 LHM-1B 두 가지 모델 제공, H100 GPU 기준 1~2초 내 처리 완료.

- 배포: Apache 2.0 라이선스로 오픈소스 제공, Hugging Face에서 데모 체험 가능(https://huggingface.co/spaces/DyrusQZ/LHM).

- 활용 사례: 게임 캐릭터 제작, VR/AR 아바타, 소셜 미디어용 동영상 콘텐츠 생성.

사이트에서는 또한 “최신 Hunyuan3D-2 프레임워크를 활용해 빠르고 효율적인 3D 모델 생성을 구현했다”며, 다양한 예시 이미지를 공개했다. 여덟 가지 샘플은 일상적인 셀카에서부터 패션 모델 사진까지, 폭넓은 적용 가능성을 보여준다. 연구진은 향후 더 다양한 데이터셋으로 모델을 강화할 계획이라고 덧붙였다.

LHM 사용 가이드: 직접 경험해보는 법

LHM을 직접 써보고 싶다면, 몇 가지 단계를 거치면 된다. 아래는 공식 GitHub와 Hugging Face 데모를 기반으로 한 실용적인 가이드다.

1. 환경 설정- 필요 사양: Python 3.10, CUDA 11.8 또는 12.1 지원 GPU(NVIDIA 권장), 최소 16GB VRAM.

- 설치 과정: GitHub에서 저장소를 클론한다. 명령어는 git clone --recursive https://github.com/aigc3d/LHM. 이후 cd LHM 으로 이동해 pip install -r requirements.txt로 의존성을 설치한다. 자세한 설치 지침은 INSTALL.md 파일에서 확인 가능하다.

- 모델 다운로드: LHM-0.5B와 LHM-1B 가중치는 Hugging Face(huggingface.co/aigc3d/LHM)에서 자동 다운로드되거나, 직접 링크(virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/)를 통해 받을 수 있다.

- 이미지 준비: 선명한 단일 인물 사진을 준비한다. 복잡한 배경은 피하고, 정면이나 약간 기울어진 각도가 적합하다.

- 명령어 실행: 터미널에서 bash ./inference.sh ./configs/inference/human-lrm-500M.yaml LHM-500M ./train_data/example_imgs/를 입력한다. 결과는 지정된 폴더에 저장된다.

- 애니메이션 추가: 모션 시퀀스를 적용하려면 bash inference.sh ${CONFIG} ${MODEL_NAME} ${IMAGE_PATH} ${MOTION_SEQ}를 사용한다. 예: ./train_data/motion_video/mimo1/smplx_params.

- 소요 시간: H100 GPU 기준 1~2초, 일반 데스크톱 GPU로는 5~10초 소요.

- 팁: 얼굴 디테일이 흐릿하면 입력 이미지 해상도를 높이거나, 머리 영역 마스크를 조정해 재시도한다.

- 메시 내보내기: 3D 메시로 변환하려면 bash ./inference_mesh.sh ${CONFIG} ${MODEL_NAME}를 실행한다.

- Hugging Face 스페이스(https://huggingface.co/spaces/DyrusQZ/LHM )에 접속해 이미지를 업로드하면 몇 초 만에 결과를 확인할 수 있다. 간단한 테스트를 원한다면 이 방법이 가장 빠르다.

LHM이 바꿀 콘텐츠 창작의 미래

LHM은 단순한 기술 이상의 의미를 지닌다. 한 장의 사진으로 3D 캐릭터를 만들고, 이를 실시간으로 움직이게 할 수 있다는 점은 창작의 문턱을 크게 낮춘다. 게임 개발자는 복잡한 리깅 과정 없이 캐릭터를 제작할 수 있고, 소셜 미디어 사용자는 평범한 셀카를 독특한 애니메이션으로 바꿔 공유할 수 있다. VR이나 AR 환경에서도 개인화된 아바타를 빠르게 구현할 가능성이 열린다.

알리바바는 이 모델을 무료로 공개하며 커뮤니티와 함께 발전시키려는 비전을 품고 있다. SNS 에서 한 개발자는 “LHM 덕분에 몇 시간 걸리던 작업이 몇 초로 줄었다”며 실용성을 극찬했다. 물론 현재의 한계를 넘어 더 다양한 시나리오에 적용되려면 시간이 필요하지만, 이미 보여준 성과만으로도 기대감은 크다.

'일상 > IT.과학' 카테고리의 다른 글

| 국내 연구진의 혁신: 형태 변형과 스피커 기능을 갖춘 OLED 패널 기술 (0) | 2025.03.25 |

|---|---|

| 펄어비스 블랙 스페이스 엔진: 빛난 기술력의 증명 (0) | 2025.03.25 |

| 엔비디아의 루빈 울트라와 파인만 AI 칩: 미래를 위한 초고성능 설계 (0) | 2025.03.25 |

| ReCamMaster: 영상 시점을 자유롭게 바꾸는 혁신 기술 (0) | 2025.03.25 |

| 스태빌리티 AI의 Stable Virtual Camera: 사진을 3D로 바꾸는 혁신 (0) | 2025.03.25 |